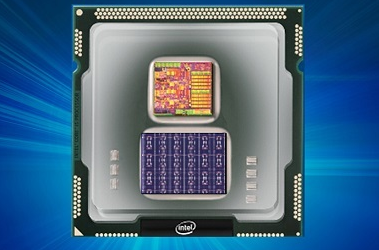

Intel对外表示,他们已经开发出了一款代号为Loihi的芯片,值得注意的是,与传统芯片不同,Loihi不是基于计算机的架构,而是使用一种称为“人造脑”的技术,以人脑为模型。

据了解,Loihi测试芯片包括模拟大脑基本机制的数字电路,它有1024个人造神经元,和1.3亿个可能的突触连接。该神经元芯片模型从神经元的沟通和学习中吸取灵感,使用可以根据时机进行调制的尖峰和塑料突触,以帮助计算机根据模式和协调自行组织和作出决策。

此外,Loihi测试芯片可以实现片上学习,也就是整个学习的训练和推理过程都将在单个芯片上完成,且芯片可以自动进行数据的实时更新,而不用等待从云端或是互联网上数据库的更新和传输。

通过使用Loihi芯片,理论上可以加速机器学习,同时将功耗要求降低到现有芯片的千分之一。与其他典型的刺激神经网络相比,该芯片的操作速度提高了100万次;在解决MNIST数字识别问题时给定准确度的条件下,与卷积神经网络和深度学习神经网络的技术相比,Loihi测试芯片在相同任务中使用的资源要少得多。

对于该芯片,Intel表示:“该芯片的自学习能力具有巨大的潜力,可以改善汽车和工业应用以及个性化机器人,即任何可以在非结构化环境中受益于自主操作和持续学习的应用程序。”

对于Loihi,Intel计划在2018年上半年将该芯片提供给专注于人工智能的大学和研究机构,以测试芯片对新型AI应用的可行性,以进一步推动该芯片的发展。Intel表示,将使用其14纳米工艺技术制作芯片,并于11月份发布第一个测试模型。

不过,虽然神经形态处理器具有理论上的优势,但芯片在实验室外尚未发挥真正的效果。此前,IBM也开发了一种称为“TrueNorth”的神经元芯片,具有4096个处理器,模拟大约2.56亿个突触。

然而,Facebook的深度学习专家Yann LeCun表示,该类型芯片不容易使用NeuFlow卷积模型来执行图像识别等任务。英特尔也承认,其神经元芯片对于某些类型的深度学习模型将不会有很好的运行效果。