依靠这一“捷径”,三星希望成为下一代AI芯片的领先地位。

《复仇者联盟2》中,绿巨人班纳博士初见奥创“初期意识体”时,他是这样形容的:

像是在思考…这不是人类的大脑…像是活动的神经元。

这之后,“觉醒”的奥创,在通过网络了解到钢铁侠“为世界穿上铠甲”的想法,以及一些武器战争的信息后,“自我思考”并得出总结:保卫世界的方案就是消灭人类。

虽然电影中有着“自我意识”的奥创是危险的,但在现实世界,能够“像人类一样思考”的智能却是一个重要课题。

就在近日,三星与哈佛大学团队想出了一个新点子——在存储芯片中“复制”人类大脑,进而实现真正意义上的类脑计算。

目前,这一成果已经发表在《自然 · 电子学》,论文标题《Neuromorphic electronics based on copying and pasting the brain》。

绘制神经元连接图很难,但是三星他们想到一条“捷径”

让芯片具备人脑计算能力,人们最早从20世纪80年代就开始研究这一课题。

最初,他们的想法是模仿大脑神经网络,也是这个思路,成了根源难题。

时至今日,也没有人能够搞清楚,到底有多少神经元相互连接,才构成了人类大脑的复杂功能。

虽然也有类脑芯片等研究成果,但在三星与哈佛大学团队看来,这类处理器的目标仍是计算AI算法,并不是真正的模拟大脑运行。也因此,他们要回到神经拟态电子学的最初目标——通过逆向工程研究大脑。

而面对“神经网络连接图”的绘制,他们也想到了一条“捷径”——复制,工具是“CMOS纳米电极阵列”。

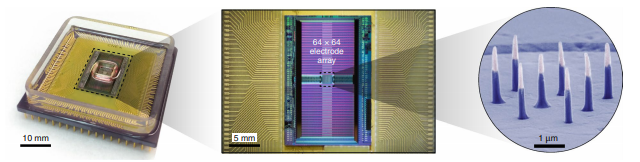

该阵列是哈佛大学的研究成果,他们在半导体芯片上集成配备了电流注入器和电压放大器的4096个垂直纳米电极,芯片上还有4096个电子通道,可以同时记录数千个神经元的突触连接。

过程中,垂直纳米电极将持续向神经元注入电流,从而让后者在研究时候保持活性。紧接着,电子通道就将负责记录。

三星与哈佛团队在小鼠身上进行了实验,通过CMOS纳米电极阵列研究小鼠皮层神经元网络,在19分钟内测量了来自1728个电极的细胞信号。

图 | 左:电镜下CMOS纳米电极阵列模仿的大鼠神经元;右:通过计算机辅助分析程序提取出的突触连接图

这还只是一小部分,在后面,该研究团队还计划研究小鼠的视网膜和嗅球/梨状皮层中神经元,它们都有着不同的功能,组织形态也不相同。未来,团队也将从这些外围神经元逐步探索大脑神经元的突触连接。

复制的下一步,是把神经元连接图“粘贴”到芯片中

在这一步,三星与哈佛团队采取的方案是利用专门设计的存储器网络下载信号,进而构建神经网络。

具体表现为,研究人员先是用计算机辅助分析程序提取出功能性神经元突触连接图,进而在该图的基础上构建、编程一个记忆网络。

至于载体的选择,他们看好闪存、磁性随机存取存储器(MRAM)、相变随机存取存储器(PRAM)和电阻式随机存取存储器(RRAM)这4种存储芯片。

需要注意的是,一个人的大脑约有1000亿个神经元,而突触连接的数量更是神经元数量的1000多倍,因此作为神经元连接图载体的存储芯片,至少需要具备存储100万亿个虚拟神经元和突触数据的容量。

这还不包括计算机辅助分析程序等过程中所需要的代码。

对于这个问题,三星他们认为,3D堆叠技术,是有可能在单个芯片上实现如此大规模容量的。

而除了存储,快速读写也是很必要的。

当前,3D闪存的写入速度已经超过100MB/s,但在这个研究项目中,利用计算机辅助分析程序,4096个通道在19分钟内也会产生约80G的数据。随着CMOS纳米电极阵列进一步扩展,数据量也会进一步增加。

显然,依照当前的读写速度,三星这款存内计算芯片距离应用“高效”还有一段距离。

将大脑神经“复制”到芯片,藏着三星的“勃勃野心”

三星方面表示,如果研究成功,研究人员可以创建一种接近大脑的存储芯片。

这意味着,该存储芯片将不仅能够做到存内计算,还将做到像人类大脑那样“思考”,做到低功耗、轻松学习的同时,也能够具备自主性和认知能力。

当然,从前面的描述可以了解到,虽然一定程度上攻克了业界对“神经元连接”的未知难题,但这一研究也存在一些挑战。

对此,三星与哈佛团队也在论文中承认,该研究还存在一些理论上的缺陷。比如大脑神经元会因为学习和生长而发生变化,但该研究采用固态芯片乘载神经元网络,无法跟踪大脑神经元发生的缓慢变化。

不过在未来,他们也憧憬可以创建一个具有可塑性的自然神经网络,进而模拟大脑神经元变化。

而值得注意的是,不管是存储芯片,还是晶圆制造的3D堆叠技术,可以说都是三星的“强项”。

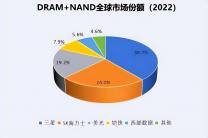

比如存储芯片市场,依据市场调机构TrendForce统计的数据,今年第二季度,三星以33.4%的市占率稳居全球第一。

又比如3D堆叠存储技术上,三星俨然是领导者队列。

但三星并不满足于此。他们毫不避讳地表示,正争取在下一代人工智能半导体领域的领先地位。

都知道,随着芯片制造工艺已经快逼近极致,如何进一步提高芯片算力成为了当下半导体产业的重点研究方向。

其中,AI是一个重要方向,可以利用算法在原有硬件基础上能够提高算力。然而从框架来看,不管是GPU、FPGA,还是ASIC,各有优势,却不能做到功耗、算力、通用性能兼得。

基于这一前提,“类脑计算”被推崇为真正AI芯片未来发展的方向,让搭载芯片的硬件做到真正“像人一样去思考”。

当下来看,这一赛道已经聚集了多个玩家,包括IBM、高通、英特尔等科技巨头,清华等高校,以及一些创企都在致力于类脑计算芯片的研究。而截至目前,还没有一个选手能够做到技术与应用的绝对领先。

不过在这其中,三星此次与哈佛联合发表的“思路”还是颇为创新的,不知道之后的研究是否能真的打破当前类脑计算的“瓶颈”。

作者:韩璐