众所周知,最近美国OpenAI的ChatGPT火爆了。

究竟有多火,看看用户发展速度就明白了,它用两天时间突破100万用户,它突破1亿用户花了两个月。

然后微软投了100多亿美元,而谷歌也全力跟进,大家认为这可能是一次新的工业革命。

说真的,这次ChatGPT的诞生,对中国人工智能领域的刺激还是很大的,很多人表示,通过ChatGPT可以看出中美人工智能差距还是比较大的。

想当初,众多媒体均表示中国在人工智能等领域并不比美国落后,甚至走到了美国前面,那么为何这次ChatGPT会诞生在美国呢?究竟是什么拖了中国ChatGPT的后腿?

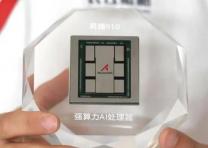

其实在我看来,归根结底还是芯片,特别是AI芯片,比如GPU、CPU、FPGA、ASIC芯片等等,目前差距还很大。

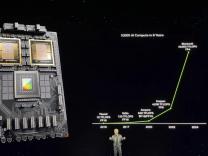

ChatGPT背后,其实是高算力支持,之有有媒体报道称,ChatGPT目前至少已经导入了1万块NVIDIA的高端GPU,其总算力已经超过了3640PF-days。

具体用价值来算的话,在算力建设这一块,ChatGPT可能有50亿美元的数据中心在后面支撑着。

但在国内,要建设如此庞大的数据中心,并不容易,特别是高端GPU显卡,其实已经买不到了,被美国禁售了,比如AMD的最高端的MI250人工智能芯片,还有英伟达的A100和H100芯片。这三款都是被用于加速人工智能任务的最新两代旗舰GPU计算芯片。

而OpenAI的GPT-3 的1750亿参数(45.3T)模型单次训练需要1024张NVIDA A100 GPU训练34天。而GPT-4需要的算力会增加两个数量级,我们从哪搞到这些芯片?

另外像CPU,FPGA、ASIC芯片,中美的差距还是相当大的。在这样的情况之下,让中国的企业,花几百亿,采购大堆的先进芯片,然后先建一个数据中心来支撑算力,想想都不太可能。

当然,除了算力之外,还有一个原因就是钱。ChatGPT的背后,有微软这样的大企业,上百亿美元的输血,放在国内也很难实现。

让一家上市企业,这么花钱,资本市场交待不过去,这笔钱批不出来的,就算谷歌、微软在看不到希望前,都不敢这么烧钱来干。

而让一家创业公司这么来干,又需要大投资机构、或者科技公司投钱,而国内要想得到上百亿美元的投资,基本上都是希望短期内看到回报的,但ChatGPT这事,可能是相当长时期看不到回报的事,国内有这个实力的投资者,科技企业,都不敢投,这也是原因之一。

当然,目前国内的百度、阿里、华为、腾讯、科大讯飞等也在摩拳擦掌,也要推出类似的产品。但总而言之,前途是光明的,但过程肯定是困难的,我们要乐观,但也要对这种事情敲响警钟。

原文标题 : 敲响警钟:拖了中国ChatGPT后腿的,还是卡脖子的芯片