近日,美国两大芯片巨头英伟达、AMD被要求停止向中国出口高端芯片一事,引发了人们对中国人工智能行业的担忧。

笔者注意到,此次英伟达、AMD此次被限制对华的芯片,主要是用于云端数据中心的高性能AI芯片,即GPGPU(通用GPU),主要用于人工智能算法的训练。其中波及到的芯片包括三项——英伟达的A100芯片、H100芯片,以及任何一项使用这两款芯片的系统;还包括AMD的M1250芯片。

超算、自动驾驶或受实质性影响

断供高端GPU会如何给国内AI模型的训练带来哪些影响?以英伟达A100为例,在2021年一项测试中,A100的深度学习性能达到了V100的3.5倍。国内几乎所有的云服务提供商都采用A100芯片来支持其数据中心的AI计算,包括阿里巴巴、腾讯、百度、浪潮、联想等,其适用范围覆盖了智慧金融、智慧城市、智慧医疗、智能制造、数据分析等领域。目前,国内依旧没有可全方位替代英伟达A100芯片的同等产品。

也许是担忧这一限令的后续影响,9月1日中午,英伟达CEO黄仁勋发布全员邮件称,将寻求最佳替代方案以满足中国客户的需求,在不能更换的地方寻求(美国政府的)许可。黄仁勋称,对A100完整性能有需求的客户,替换产品或将不能满足他们的需求。然而,对于大多数客户来说,替代产品应该可以满足他们的需求。

但问题在于,“大多数客户”可能能够从英伟达处得到替代品满足需求,但对于BAT之流的大厂而言,如果必须采用相对低端的芯片来继续完成原来采用高端芯片时达到相应的算力和处理速度要求,无疑会给企业带来更高的运营成本。

在人工智能行业场景中,GPU不仅被应用在数据中心、超级计算器、边缘计算等领域,还被用广泛用在智能汽车生态中。

早在2017年,英伟达率先推出至今仍然业界领先的Volta架构芯片Tesla V100,V100有210亿个晶体管,用300W功率提供了7.8TFLOPS的推断算力。而A100的算力直接是前者的20倍,它采用台积电(TSMC)7nm工艺,拥有540亿个晶体管,它是一块3D堆叠芯片,面积高达826mm^2,GPU的最大功率达到了400W。此外,这块GPU上还搭载了容量40G的三星HBM2显存,第三代Tensor Core。同时它的并联效率也有了巨大提升,其采用带宽 600GB/s 的新版 NVLink,几乎达到了 10 倍 PCIE 互联速度。

目前,国内的蔚来、小鹏、毫末智行等都在基于英伟达A100打造自动驾驶训练中心。如今美国政府这一道禁令宣告断供高性能AI芯片,势必会对国内智能汽车的自动驾驶产业发展造成实质性影响。

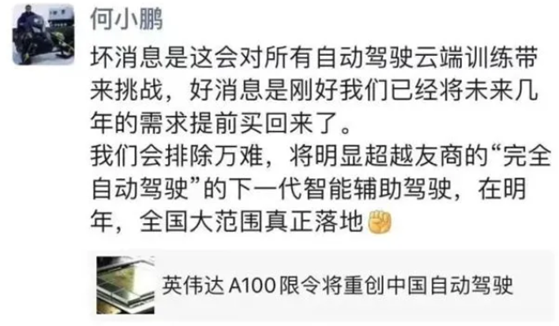

为此,何小鹏还发表了一条朋友圈称:坏消息是这会对所有自动驾驶云端训练带来挑战,好消息是刚好我们已经将未来几年的需求提前买回来了。我们会排除万难,将明显超越友商的“完全自动驾驶”的下一代智能辅助驾驶,在明年,全国大范围真正落地。

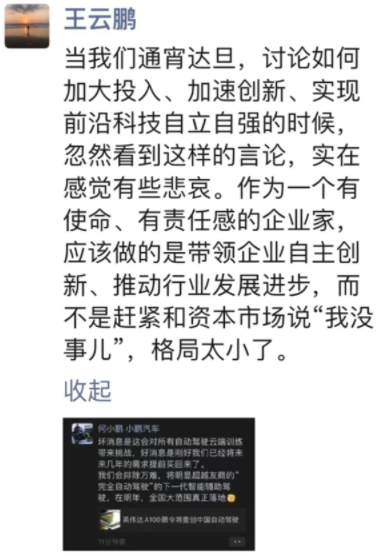

何小鹏的上述言论引发了不少业内人士不满,其中就包括百度副总裁王云鹏。9月2日,王云鹏就何小鹏的言论进行了一番批判:当我们通宵达旦,讨论如何加大投入、加速创新、实现前沿科技自立自强的时候,忽然看到这样的言论,实在感觉有些悲哀。作为一个有使命、有责任感的企业家,应该做的是带领企业自主创新、推动行业发展进步,而不是赶紧和资本市场说“我没事儿”,格局太小了。